Custos da IA da DeepSeek superam em muito os US$ 5,5 milhões declarados e podem ter atingido US$ 1,6 bilhão com 50.000 GPUs Nvidia

A DeepSeek, empresa chinesa de inteligência artificial, causou grande impacto na indústria bilionária de IA recentemente com o lançamento do seu modelo R1, que supostamente compete com o O1 da OpenAI, apesar de ter sido treinado com apenas 2.048 Nvidia H800s e um custo estimado em US$ 5,576 milhões. No entanto, um novo relatório aponta que os custos reais da empresa chegaram a US$ 1,6 bilhão e que a DeepSeek tem acesso a cerca de 50.000 GPUs Hopper.

A alegação de que a DeepSeek conseguiu treinar o R1 usando apenas uma fração dos recursos exigidos por grandes empresas de tecnologia investidas em IA fez com que as ações da Nvidia perdessem US$ 600 bilhões em valor de mercado em um único dia. Se uma startup chinesa conseguiu criar um modelo tão poderoso sem gastar bilhões nas GPUs mais avançadas da Nvidia, o que impediria outras empresas de fazerem o mesmo?

Mas será que a DeepSeek realmente criou seu modelo Mixture-of-Experts, que ainda domina as paradas da App Store da Apple, com um custo tão baixo? O relatório da SemiAnalysis afirma que não.

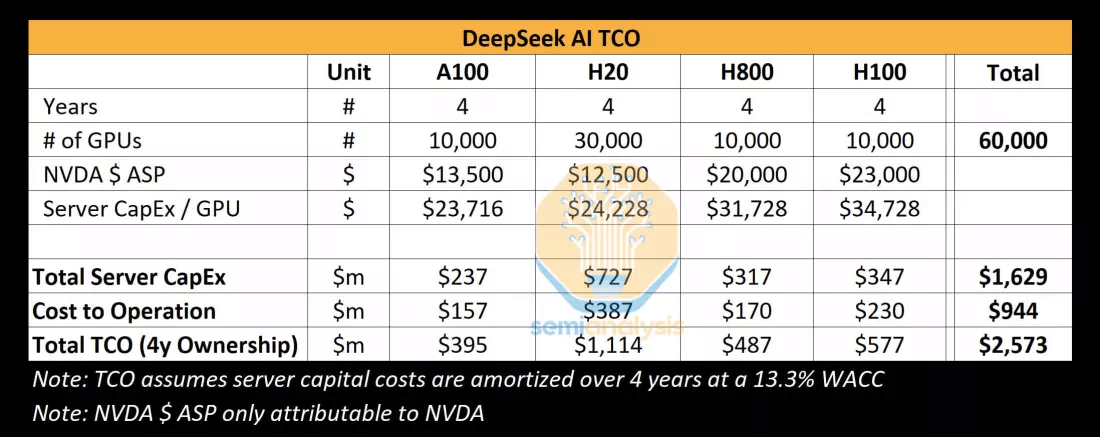

A empresa de análise de mercado escreve que a DeepSeek tem acesso a cerca de 50.000 GPUs Hopper, incluindo 10.000 H800s e 10.000 H100s, além de pedidos para muitas outras unidades do modelo H20, específico para o mercado chinês. Essas GPUs são compartilhadas entre a High-Flyer, um fundo de hedge quantitativo que controla a DeepSeek, e a própria startup. Os recursos computacionais estão distribuídos em diversas localizações geográficas e são utilizados para operações de trading, inferência, treinamento e pesquisa.

O relatório da SemiAnalysis afirma que a DeepSeek investiu muito mais do que os US$ 5,5 milhões alegados, que representariam apenas um pequeno recorte do custo total. O investimento total da empresa em servidores está estimado em cerca de US$ 1,6 bilhão, com aproximadamente US$ 944 milhões destinados a custos operacionais. Enquanto isso, os investimentos em GPUs ultrapassam US$ 500 milhões.

Para efeito de comparação, o treinamento do modelo Claude 3.5 Sonnet, da Anthropic, custou dezenas de milhões de dólares, mas a empresa ainda precisou levantar bilhões em investimentos do Google e da Amazon.

Outro ponto destacado é que a DeepSeek recrutou toda a sua equipe exclusivamente na China, o que contrasta com outras gigantes chinesas de tecnologia, como a Huawei, que vêm tentando atrair talentos do exterior, especialmente funcionários taiwaneses da TSMC. Supostamente, a DeepSeek oferece salários acima de US$ 1,3 milhão para candidatos promissores, muito mais do que outras empresas chinesas de IA pagam.

Além disso, a DeepSeek tem a vantagem de operar seus próprios datacenters, em vez de depender de provedores de nuvem externos. Isso permite mais experimentação e inovação em toda a sua infraestrutura de IA. Segundo a SemiAnalysis, a DeepSeek é hoje o melhor laboratório de “open weights” (pesos abertos), superando esforços de empresas como Meta (Llama), Mistral e outras.