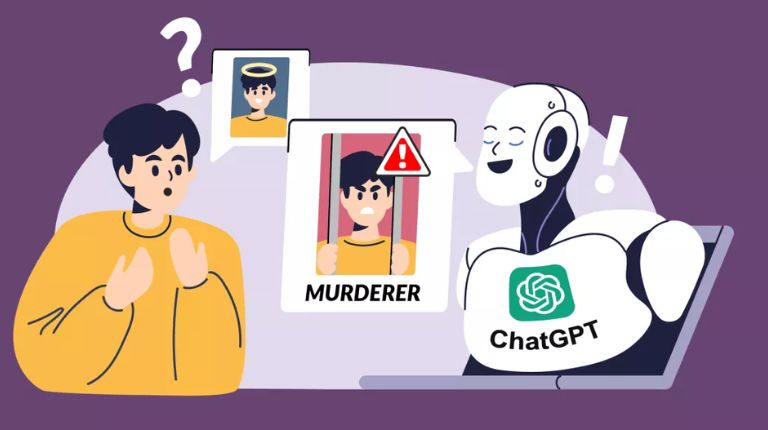

Homem registra queixa contra o ChatGPT após IA afirmar falsamente que ele assassinou seus filhos

Mesmo com a crescente adoção da inteligência artificial generativa, esses sistemas ainda estão sujeitos a alucinações. Sugerir que alguém coloque cola na pizza ou coma pedras é uma coisa, mas o ChatGPT afirmar falsamente que um homem passou 21 anos na prisão por matar seus dois filhos é algo muito mais grave.

O norueguês Arve Hjalmar Holmen entrou em contato com a Autoridade Norueguesa de Proteção de Dados depois de decidir testar o que o ChatGPT sabia sobre ele.

O chatbot respondeu com sua habitual confiança, afirmando erroneamente que Holmen havia assassinado dois de seus filhos e tentado matar o terceiro. Além disso, afirmou que ele havia sido condenado a 21 anos de prisão por esses crimes fictícios.

Embora a história fosse completamente inventada, havia elementos reais da vida de Holmen que o ChatGPT acertou, como o número e o gênero de seus filhos, suas idades aproximadas e o nome de sua cidade natal, tornando as alegações falsas sobre assassinato ainda mais preocupantes.

Holmen afirmou que nunca foi acusado ou condenado por qualquer crime e que é um cidadão exemplar.

Ele entrou em contato com a organização de direitos de privacidade Noyb sobre a alucinação. O grupo conduziu uma investigação para garantir que o ChatGPT não estivesse confundindo Holmen com outra pessoa de nome semelhante. Também verificou arquivos de jornais, mas não encontrou nada que pudesse explicar por que o chatbot criou essa história macabra.

O modelo de linguagem do ChatGPT foi atualizado e não repete mais essa história quando perguntado sobre Holmen. No entanto, a Noyb, que já teve conflitos anteriores com a OpenAI devido a informações falsas geradas pelo ChatGPT sobre pessoas, ainda apresentou uma queixa à Autoridade Norueguesa de Proteção de Dados, Datatilsynet.

Segundo a queixa, a OpenAI violou regras do GDPR (Regulamento Geral de Proteção de Dados da União Europeia), que exigem que empresas que processam dados pessoais garantam sua precisão. Caso as informações não sejam corretas, elas devem ser corrigidas ou excluídas. No entanto, a Noyb argumenta que, como o ChatGPT reutiliza dados dos usuários para treinar seu sistema, não há como garantir que as informações incorretas tenham sido completamente removidas do conjunto de dados do modelo.

A Noyb também afirma que o ChatGPT não está em conformidade com o Artigo 15 do GDPR, o que significa que não há garantia de que uma pessoa possa recuperar ou visualizar todas as informações armazenadas sobre ela no banco de dados da IA. “Esse fato, compreensivelmente, ainda causa angústia e medo ao reclamante, [Holmen]”, escreveu a Noyb.

A organização solicita que a Datatilsynet ordene que a OpenAI exclua os dados difamatórios sobre Holmen e ajuste seu modelo para eliminar resultados imprecisos sobre indivíduos, algo que não seria uma tarefa simples.

Atualmente, a forma como a OpenAI tenta se proteger nesses casos é por meio de um pequeno aviso no rodapé da página do ChatGPT, que diz: “O ChatGPT pode cometer erros. Verifique informações importantes”—como, por exemplo, se alguém realmente é um assassino.